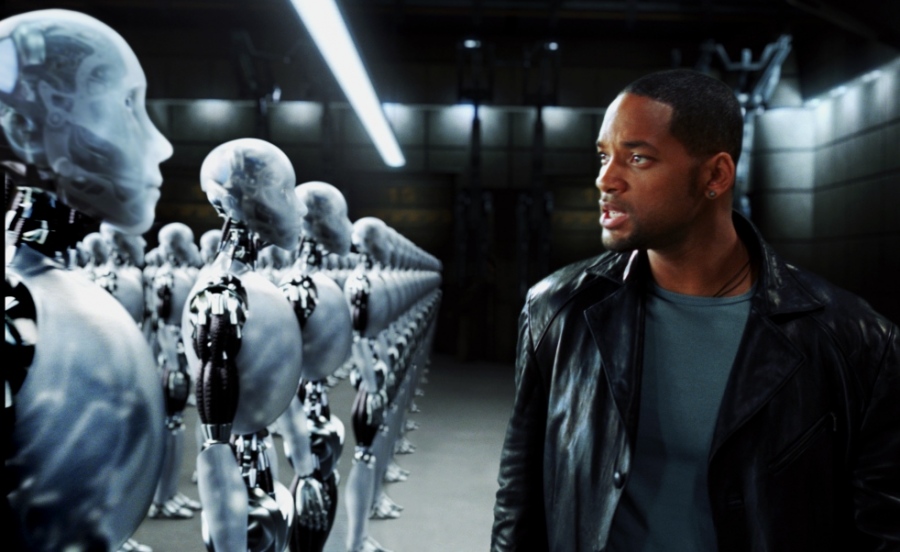

Künstliche Intelligenz und die Frage der Ethik

In den letzten Jahrzehnten ist im Bereich der künstlichen Intelligenz viel geschehen. 1953 schuf der Mathematiker Alan Turing die theoretischen Grundlagen der künstlichen Intelligenz. Er entwickelte unter anderem ein Computerprogramm zum Schachspielen. Allerdings musste er die komplizierten Berechnungen dazu selbst ausführen, denn es gab noch keine passende Hardware.

Schach und mehr ist möglich

Künstliche Intelligenz hat sich deutlich verbessert. Gerade hat ein Computer, der auf der Technologie von «Google DeepMind» arbeitet, zwei von zwei «Go»-Spielen gegen den Südkoreaner Lee Sedol gewonnen. «Go» gilt als das komplexeste Strategiespiel überhaupt und Sedol ist einer der besten Spieler weltweit. Doch die Systeme künstlicher Intelligenz, die es bisher gibt, sind meist stark spezialisiert. Das heisst, dass eine Maschine, die «Go» spielt, sich nicht die Schnürsenkel binden kann. Und eine Maschine, die irgendein Foto betrachten und sofort als Katze identifizieren kann (ein hochkomplexer Vorgang, denn vielleicht ist sie von hinten abgebildet oder hat die katzentypischen Augen geschlossen), versteht den einfachsten Witz nicht.

All das soll aber nicht darüber hinwegtäuschen, dass die Forschung zur künstlichen Intelligenz tatsächlich grosse Fortschritte macht. Die Suchmaschine «Google» zum Beispiel arbeitet längst nicht nur mit abgespeicherten Suchwörtern, sondern hat über «Google Brain» Algorithmen, die vernetzt und «intelligent» eigene Antworten finden. Dasselbe gilt für «Siri» und «Cortana», die sprachgesteuerten Assistenten von Smartphones.

Wir sind verantwortlich für das, was wir schaffen

In einem Interview über künstliche Intelligenz und ihre theologische Bedeutung erklärte «Science Mike» McHargue kürzlich, dass er zwar nicht abschätzen könne, in welchem Zeitraum sie sich weiterentwickeln werde, dass ihr Fortschritt aber unaufhaltsam sei. Und er schloss daraus, dass wir als Menschen eine Art Verantwortung für das übernehmen müssten, was wir schaffen. Selbst, wenn es kein «Leben» sei, sondern nur eine «Wesenheit». Provozierend hielt er fest: «Man könnte sich sogar eine digitale Intelligenz mit Bewusstsein vorstellen, die weder Schmerzen, Leiden noch Angst empfinden kann. Wenn Sie zum Beispiel eine solche Intelligenz geschaffen haben, die ausserordentlich klug ist, ist es dann ethisch vertretbar, sie zu deaktivieren oder zu löschen? … Und falls sie Angst und Leiden empfinden kann, sollte sie nicht dieselben Rechte und den gleichen Schutz wie Menschen bekommen?»

Maschinen können keine Verantwortung übernehmen

Näher an unserer Wirklichkeit ist sicher die Frage, ob Maschinen denn irgendwelche (moralische) Verantwortung übernehmen können. Relevant ist diese Fragestellung zum Beispiel bei den selbstfahrenden Autos, die gerade in Schweden, USA oder Deutschland unterwegs sind. Bisher hiess es immer, dass sie absolut sicher seien, die einzige Fehlerquelle im Strassenverkehr wäre der Mensch. Doch inzwischen kam es zu ersten Unfällen. Wer trägt in solch einem Fall die Verantwortung? Die automatische, «intelligente» Steuerung? Und nach welchen ethischen Massstäben ist diese programmiert? Es ist der Alptraum jedes Autofahrers, doch es kommt immer wieder vor: ein unabwendbarer Unfall. Wie soll ein Programmierer selbstfahrende Autos hierfür vorbereiten? Sollen sie eher das Kleinkind oder die Rentnerin überfahren, wenn kein Ausweichen mehr möglich ist? Was sich für manch einen spitzfindig anhört, ist für den Philosophen Oliver Bendel ein Punkt, der unbedingt geklärt werden muss. Darf ein Auto das Leben eines Menschen opfern, um viele zu retten? Oder soll es im Zweifelsfall das Leben seiner Insassen gefährden?

Im Sonntagsblatt warnt Bendel davor, Roboter-Autos komplexe Entscheidungen zu überlassen. «Die Maschine kann keine Verantwortung übernehmen» und seiner Meinung nach auch keine Schuld tragen. Er ergänzt: «Wenn wir über Leben und Tod entscheiden, muss es jemanden geben, der die Verantwortung trägt oder die Schuld auf sich lädt.» Damit bringt Bendel einen Gedanken in die aktuelle Diskussion ein, der so alt ist wie die Menschheit. Schon im Schöpfungsbericht beauftragt Gott den Menschen, die Welt zu beherrschen bzw. verantwortlich zu verwalten (1. Mose Kapitel 1, Vers 28). Intelligenz braucht offensichtlich die Ergänzung durch Verantwortung.

Die Frage nach einer Ethik zur künstlichen Intelligenz wird von vielen Informatikern gern vertagt. «So weit sind wir noch nicht …» Gerade deshalb sollte die Diskussion darüber jetzt stattfinden.

Zum Thema:

Rückbesinnung auf Europas Werte: «Maschinen werden mehr geschätzt als Werte»

Das Gehirn Kein Computer wird je mit ihm gleichziehen!

Roboter: Menschenrechte für Maschinen?

Datum: 25.07.2019

Autor: Hauke Burgarth

Quelle: Livenet / Sonntagsblatt / Relevant Magazine